2025年6月,GPT-4o对话模型全新优化教程

2025年6月,GPT-4o对话模型经过多项技术升级,实现了更自然流畅的交互体验和更精准的语义理解。本文将全面讲解GPT-4o对话模型的全新优化方法,帮助开发者和用户高效利用该模型构建智能对话系统。

一、优化目标与核心改进

- 提升上下文理解能力

支持超长上下文(最高128K tokens),实现多轮对话中更精准的语义关联。 - 增强情感识别与回应适配

识别用户情绪,调整回答语气和内容,提高交互人性化。 - 减少无关与重复内容

通过改进的惩罚机制,降低重复回答和偏离主题的概率。

二、优化方法详解

1. 提示设计(Prompt Engineering)

- 使用系统角色设定引导模型语气和风格,如“你是一位耐心细致的客服代表”。

- 明确用户意图,提供丰富上下文信息,减少理解偏差。

2. 参数调整

- temperature:设置为0.3-0.5,平衡创造力与准确性。

- presence_penalty 和 frequency_penalty:增加惩罚系数,减少重复输出。

- max_tokens:根据对话需求合理设置响应长度。

3. 上下文管理

- 利用对话历史摘要功能,压缩并提炼关键信息,保持上下文连贯。

- 定期清理无关信息,避免上下文膨胀导致性能下降。

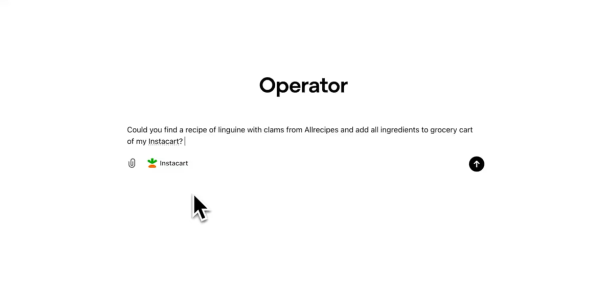

4. 多模态融合

- 在对话中结合图像、语音输入,丰富交互方式,提升用户体验。

三、实战技巧

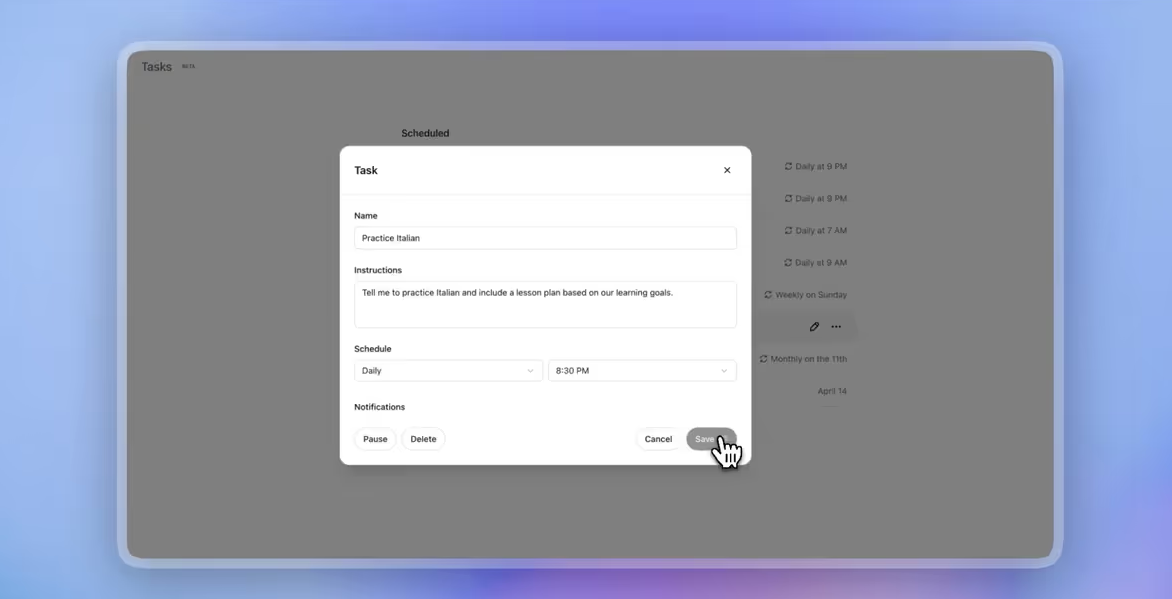

- 多轮迭代生成

先生成简短回答,再根据用户反馈补充细节。 - 动态提示更新

根据对话进展实时调整提示内容,精确引导模型输出。 - 异常检测与纠正

结合规则和模型自检,自动识别和修正回答中的错误。

四、示例代码片段(Python)

import openai

openai.api_key = "你的API密钥"

response = openai.ChatCompletion.create(

model="gpt-4o",

messages=[

{"role": "system", "content": "你是一位专业且耐心的对话助手。"},

{"role": "user", "content": "请帮我解释一下机器学习的基本概念。"}

],

temperature=0.4,

presence_penalty=0.6,

frequency_penalty=0.6,

max_tokens=250

)

print(response.choices[0].message['content'])

五、总结

通过科学的提示设计、参数调节和上下文管理,2025年6月版GPT-4o对话模型实现了更智能、高效的交互效果。掌握这些优化技巧,助力构建更加人性化和精准的智能对话系统。