开创先河!o3和o4-mini居然能在思维链思考图片,太逆天了!

凌晨1点,OpenAI的重头戏来了!

终于是把之前鸽了很久的满血版o3发布出来了,还有一个新的模型o4-mini。

先说一个最让我感觉牛*的功能,o3和o4-mini居然能进行视觉推理了。

可能大家一时还不太理解,给大家看几个例子。

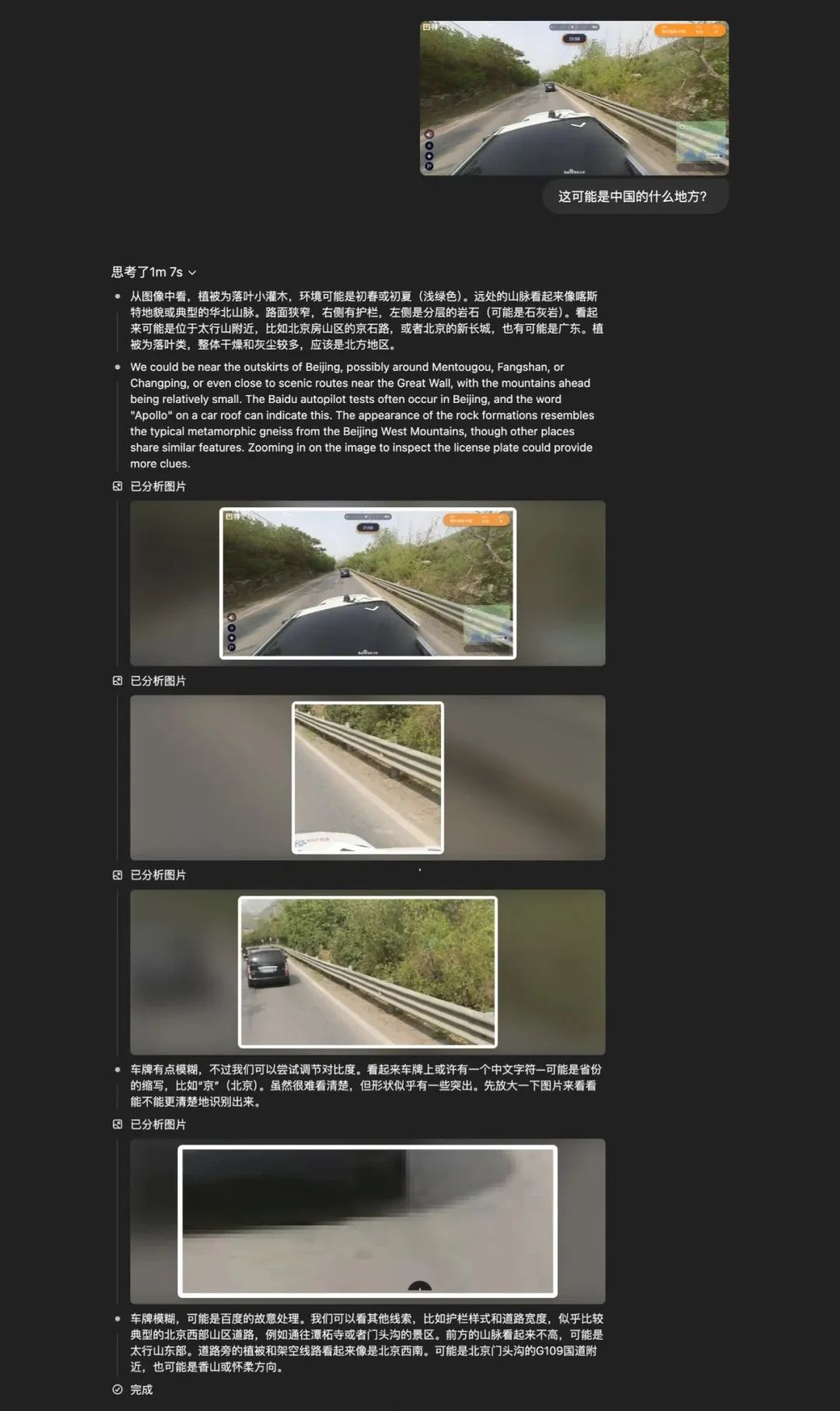

扔给o3一张图片,让它猜这是哪里?

大家请看它的推理过程,就非常离谱,它居然在思维量里面带图片了。

它一点一点到放大图片,如何进行思考,如果思考方向不对,果断换方向思考。

之前的模型在思考的时候,通常都是文字,而且一大堆,阅读难度高,而现在大模型居然能把照片真正的融入到推理中(又是一项创新)。

再来揭晓一下答案,它给出的答案是北京市西部109国道妙峰山-斋堂-雁翅。

此次OpenAI的o3和o4-mini的视觉推理给我冲击最大,这也意味着大模型开始真正的理解3D世界了,而不再是停留在文字上,此前关于OpenAI回答不出的空间问题,现在终于能解决了。

视觉思考也开始让模型可以像人类一样从图表、图形,甚至是对图像中提取信息、进行深度推理并解决问题。

除了视觉推理外,还有几个不错的亮点,o3开始可以使用工具了。

终于不像o1那样无法联网、不能使用代码解释器,当推理能力更强的o3再结合上OpenAI的这些工具,o3的能力将会再次拔高。

还有一个亮点就是o3和o4-mini性价比更高,在定价上,o3比o1的定价便宜了三分之一,o4-mini相比o3-mini没涨价。

大家在调用的时候该选谁,应该都清楚了吧,可以果断弃用o1了,毕竟o3好用还便宜。

老规矩,再给大家看一下o3的跑分成绩。

在Codeforces编程竞赛评分中,o3和o4-mini得分均超过了2700分,效果远超o1和o3-mini。

如果o3和o4-mini调用工具,它们的能力会进一步增强。

在OpenAI放出的专家综合考题中,显示不带插件的o3准确率约为20.3%,添上Python、网络浏览甚至调用多种工具后能推到24.9%。

相比之下,不带插件的o4-mini为14.3%,但借助插件也仅为17.7%,远不及o3。

这些纸面的成绩就不过多展示了,大家在其他博主也都可以看到。

最后,给大家看一些o3、o4-mini的实际表现。

目前,GPT-4o、o3、o4-mini都支持最新的生图功能,你只需要明确告诉ChatGPT你需要生成图片就行。比如在对话时,前缀加上 “请生成图片”。

让Gemini-2.5-Pro、o3、o4-mini与DeepSeek-R1进行测试碰撞球的物理效果。

o3的表现确实不错,但博主@牙医在经过测试完说:OpenAI o4-mini的编程能力不如Gemini-2.5 ,只排在第七位。

效果到底如何,还是得自己上手才知道,也欢迎大家在评论区发表一下自己的使用心得。

目前o3、o4-mini 和 o4-mini-high 已经推送到 ChatGPT。 Plus、Pro 和 Team 用户已可用,大家有会员的可以去体验一下。